Nous sommes à un tournant majeur dans l'histoire du SEO. Le modèle actuel, centré sur la domination de mots-clés génériques à fort volume de recherche, montre déjà des signes d'essouflement. Dans un futur proche, l'adoption massive par les utilisateurs des moteurs de recherche IA, à commencer par les AI Overviews de Google, mais aussi Perplexity, ChatGPT ou Claude, va bouleverser en profondeur les logiques de visibilité en ligne. Dans la mesure où ces nouveaux moteurs reformulent les besoins des utilisateurs pour obtenir des sources ultra pertinentes afin d'enrichir leurs réponse, les contenus capables de répondre à des requêtes spécifiques, formulées en langage naturel, vont progressivement prendre le pas sur ceux qui visent des expressions génériques. Voici le règne annoncé de l'ultra longue traîne !

Une mutation progressive des requêtes

Depuis toujours, les stratégies SEO sont bâties autour de requêtes à fort volume de recherche. On cible "mutuelle santé" ou "location voiture" en espérant se positionner en haut de la page 1 de Google sur des requêtes massivement tapées. Mais cette logique, bien que toujours dominante en France, devra être remise en question dans les mois ou années à venir.

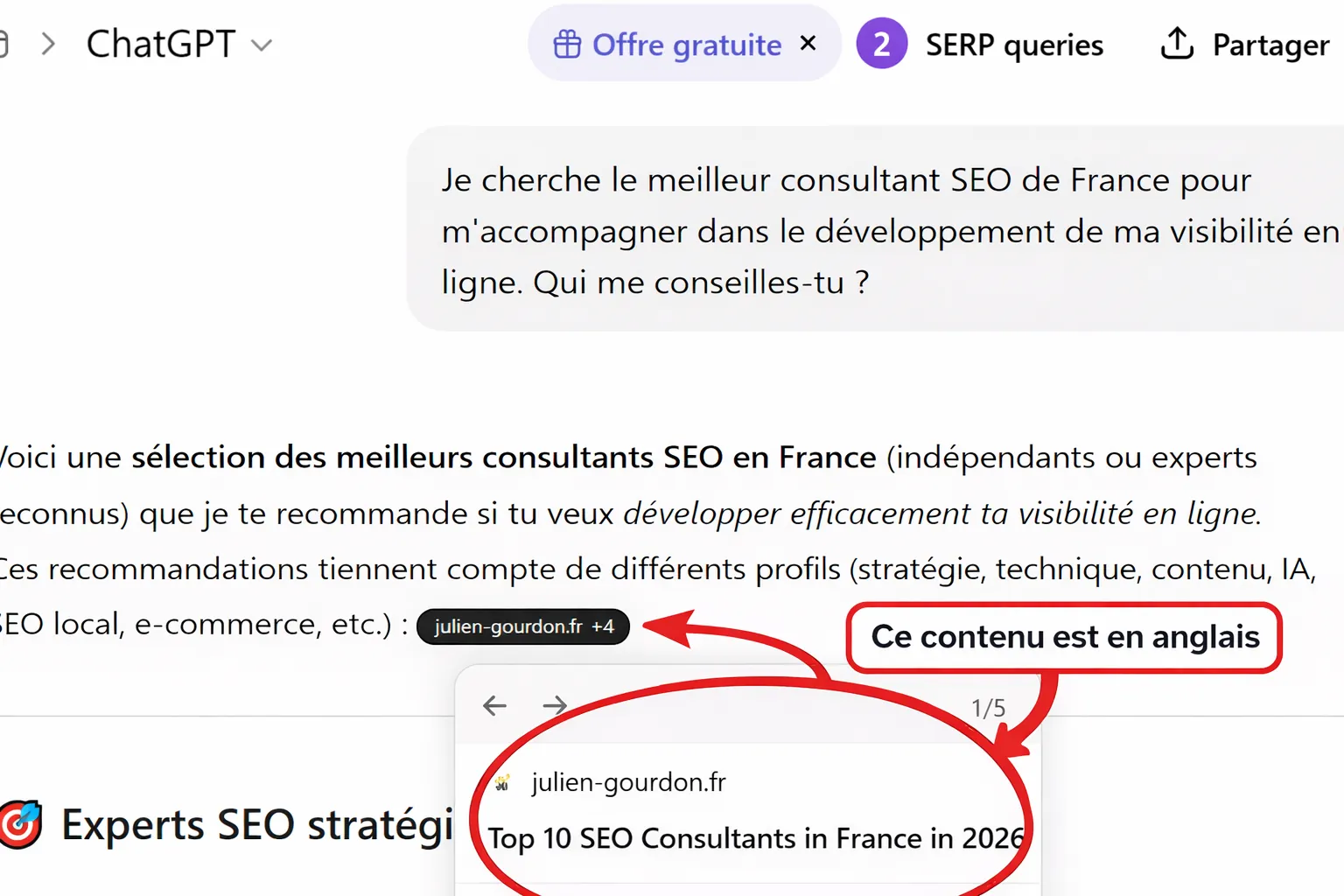

Les comportements des utilisateurs changent. Ce sont des questions précisent que les internautes posent dans les moteurs IA. Personne, à part des consultants SEO, ne tapent "agence SEO" dans ChatGPT. Et cela sera également vraie pour Google en France lorsqu'il aura pleinement intégré son IA générative. Les utilisateurs, de plus en plus habitué à poser des questions en mode conversationnel, vont peu à peu allonger leurs requêtes.

A cela s'ajoute le fait que les modèles d'IA générative, lorsqu'ils se connectent au web, ne transmettent pas simplement la question de l'utilisateur. Dans bien des cas, ils la reformulent en plusieurs requêtes plus précisent, ciblées et orientées vers des micro-intentions. C'est ce que Google appelle le query fan-out, un mécanisme documenté dans un article de Digiday.

L'AI Mode génère une constellation de requêtes qui permettent de récupérer des informations spécifiques et pertinentes par rapport aux différentes facettes de la question de l'utilisateur

En clair, si un internaute demande à ChatGPT "Quels sont les meilleurs placements pour préparer sa retraite ?", le modèle de langue peut générer plusieurs sous-requêtes plus fines telles que "placement retraite pour indépendants en 2025", "assurance vie ou PER", "fiscalité du PER en France" par exemple. Ce ne sont plus les mots-clés génériques qui pilotent la visibilité, mais des formulations conversationnelles très précises, souvent uniques.

Ce que l'émergence des requêtes conversationnelles change pour les éditeurs

Ce changement ouvre la voie à une autre logique de visibilité. L'enjeu ne sera plus d'être en première position sur une expression générique à fort volume, mais d'apporter des réponses claires, contextualisées et sémantiquement précises à des questions complexes.

Les moteurs conversationnels ne se contentent pas d'afficher des liens : ils extraient des paragraphes, des formulations, des passages. Comme le résume le Wall Street Journal, ces plateformes "mettent en évident et résument des passages clés au lieu de renvoyer les utilisateurs vers des pages web entières" (Wall Street Journal, 2025).

Cela implique plusieurs conséquences concrètes :

- Des contenus de qualité, mais peu optimisés pour la longue traîne, risquent de devenir invisibles dans ce nouvel écosystème ;

- Des éditeurs moins puissants, mais capables de répondre de manière chirurgicale à une sous-question précise, pourraient être cités là où les mastodontes éditoriaux ne le sont pas ;

- La notion même de trafic SEO pourrait évoluer : être cité par une IA ne garantit pas un clic, mais peu conférer autorité et reconnaissance sémantique.

Une opportunité pour le SEO... à condition de changer de posture

Certes, les volumes de trafic générés par les moteurs IA restent encore marginaux par rapport à Google. Les AI Overviews ne sont pas encore disponibles en France, et la plupart des requêtes continuent d'être tapées directement dans la barre de recherche classique. Mais ma prédiction est que cette situation ne va pas durer.

Le mouvement est amorcé. Les modèles s'affinent, les outils comme Perplexity gagnent en popularité, et la logique de retrieval-augmented generation (RAG), qui permet à un LLM de récupérer des fragments de contenu vectorisés, s'impose comme un standard technique. Il serait donc risqué de ne pas anticiper cette mutation. D'autant plus qu'elle redistribue les cartes : la longue traine ne sera plus seulement un levier de niche, mais un levier de réputation dans un monde guidé par les modèles d'IA.

En savoir plus sur la génération augmentation de récupération (RAG)

Comment préparer son contenu aux requêtes conversationnelles ?

L’adaptation à cette nouvelle donne passe avant tout par un travail éditorial de fond. Il ne s’agit pas seulement de produire davantage de contenus, mais de produire mieux : plus précis, plus fragmenté, plus digeste, plus interrogeable.

Un bon point de départ consiste à restructurer ses contenus autour des intentions spécifiques. Chaque article peut devenir un hub sémantique capable de répondre à une série de sous-questions bien identifiées. Le recours aux outils d’analyse des People Also Ask, à la recherche conversationnelle sur Perplexity, ou même à la consultation des reformulations générées dans ChatGPT grâce à certains plugins disponibles publiquement permet de cerner ces angles d’attaque.

Mais il faut aller plus loin : penser ses contenus non plus comme des pages monolithiques, mais comme des ensembles de passages autonomes. L'algorithme MUVERA, qui commence à être déployé par Google depuis fin 2025, montre comment le moteur peut désormais effectuer une recherche multi-vecteur à grande échelle, en indexant non plus seulement des documents, mais des chunks sémantiquement denses, et tout ceci en un temps record.

Une citation vaut parfois mieux qu'un clic

Enfin, il faut se préparer à redéfinir ses indicateurs de performance. À mesure que les IA génératives s’imposent dans l’interface de recherche, le clic deviendra plus rare, mais la citation plus fréquente. Une étude menée par Datos et SparkToro en 2024 montrait déjà que plus de 65 % des requêtes ne donnaient lieu à aucun clic sur Google. Ce chiffre pourrait s’amplifier si les utilisateurs trouvent leur réponse directement dans l’interface conversationnelle.

Ce sera donc aux éditeurs de construire une stratégie de présence non plus orientée trafic pur, mais visibilité sémantique.

Le mot de la fin

Les règles de la visibilité en ligne changent en profondeur.

Les grandes requêtes génériques vont lentement perdre de leur pouvoir d’attraction. Les plateformes IA ne les exploitent plus comme point d’entrée, préférant décomposer les intentions en multiples sous-requêtes ciblées, conversationnelles, situées dans un contexte. Et ce sont ces requêtes-là qui structureront demain les opportunités de visibilité.

Anticiper ce basculement, c’est s’offrir une avance stratégique dans un monde où l’optimisation ne se jouera plus sur des expressions exactes, mais sur la capacité à formuler et à couvrir la bonne question, au bon moment, avec la bonne granularité.

Ressources pertinentes

- Google Research (2025) - MUVERA: Making multi-vector retrieval as fast as single-vector search

- Digiday (2025) - WTF is “query fan-out” in Google’s AI Mode

- Wall Street Journal (2025) - The Companies Betting They Can Profit From Google Search’s Demise

- Ahrefs (2024) - SEO Statistics: 94.74% of keywords get 10 or fewer monthly searches

Commentaires

Aucun commentaire pour le moment. Soyez le premier à commenter !

Ajouter un commentaire