Alors que l'IA génère des millions de pages par jour, Google ne récompense plus le volume, mais la valeur. C'est ce qu'a dit en substance Liz Reid, vice-présisdente et head of Google Search, dans un épisode du podcast Bold Name du Wall Street Journal mis en ligne le 10 octobre 2025. Seul le contenu humain, expert et utile a vocation à survivre dans les pages de résultats du moteur de recherche.

Liz Reid justifie cette approche par un changement profond du comportement des utilisateurs. Saturés de contenus génériques et superficiels, les internautes privilégient un contenu plus profond et plus riche, qui respire l'humanité. Cela englobe des contenus qui témoignent d'un temps investi, d'un savoir-faire et d'une expertise, d'une authenticité et d'une perspective unique, au détriment de la production de masse sans âme et sans saveur.

Pour Google, le message est clair : si vous ne faites que recopier des informations déjà présentent sur le web, si vous n'apportez pas de réelle valeur ajoutée par rapport à l'existant, le moteur de recherche vous considère désormais comme du spam et vous n'avez pas vocation à vous positionner dans la SERP.

Revenons dans cet article sur l'évolution de la notion de qualité aux yeux de Google, des origines jusqu'à nos jours.

Évolution des algorithmes Google liés à la qualité du contenu

Google a progressivement intégré des algorithmes visant à évaluer la qualité des pages et des sites web. Historiquement, le classement reposait surtout sur la pertinence (mots-clés, liens) et la popularité (PageRank). Au fil du temps, Google a ajouté des systèmes pour identifier et promouvoir le contenu de haute qualité.

Google Panda (2011)

Première mise à jour majeure axée sur la qualité du contenu. Panda a pénalisé les pages « pauvres » (contenu très court, dupliqué, sans valeur ajoutée) et amélioré le classement des sites offrant un contenu original et fouillé. Cet algorithme, devenu un composant du cœur de l'algorithme Google, a évolué en interne sous le nom de Coati, mais conserve le même objectif : évaluer algorithmiquement la qualité globale d'un site.

Google Penguin (2012)

Axé sur la qualité des liens entrants. Il a sanctionné les sites aux profils de liens artificiels ou spammy (achat de liens, sur-optimisation d'ancres), afin de ne compter que les backlinks de qualité comme signal positif de réputation.

Hummingbird (2013)

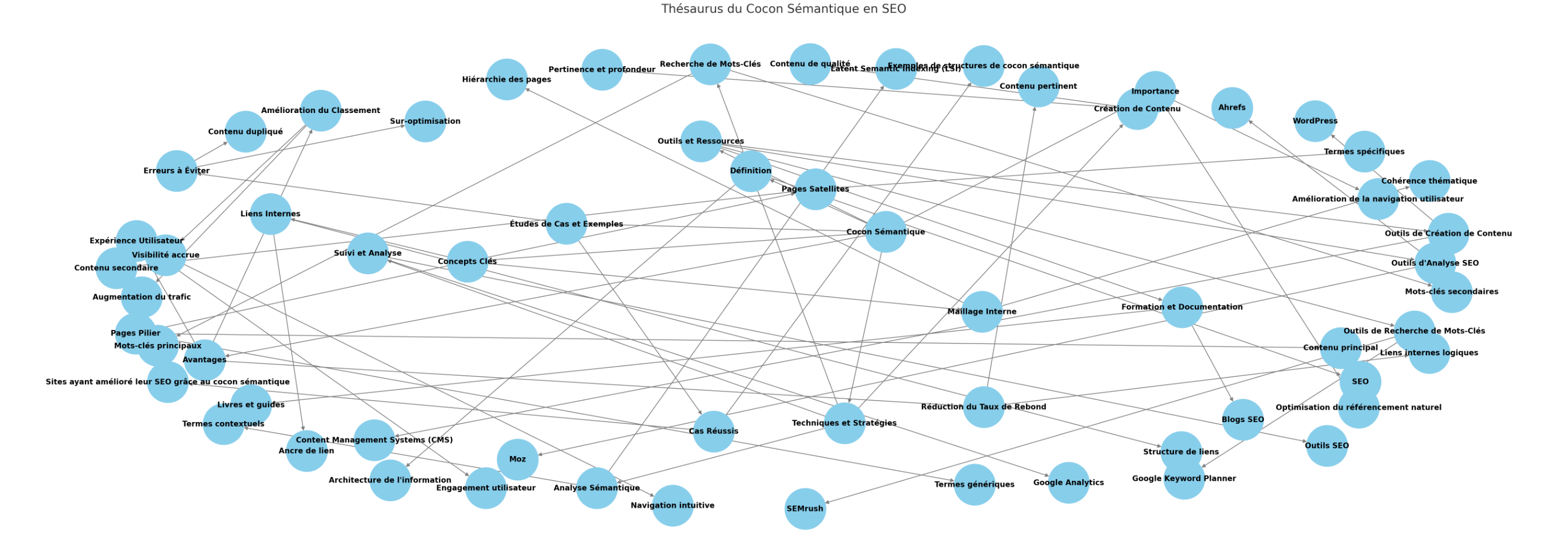

Réécriture du moteur de recherche intégrant la compréhension sémantique. Indirectement, cela a permis à Google de mieux interpréter le contenu pertinent et de qualité même si les mots-clés exacts ne sont pas présents, en se concentrant sur le sens et la profondeur du contenu.

RankBrain (2015)

Système d'IA (machine learning) aidant Google à mieux interpréter les requêtes complexes et à ajuster le classement en fonction de signaux de satisfaction utilisateur. RankBrain peut modifier le poids de certains signaux pour privilégier les résultats jugés plus utiles, même s'ils ne contiennent pas tous les mots de la requête. Cela a ouvert la porte à la prise en compte indirecte de signaux comme le comportement des utilisateurs.

Notion de E-A-T (2014)

Google introduit dans ses consignes de qualité aux évaluateurs humains le concept de Expertise, Autorité, Fiabilité (E-A-T), enrichi en 2022 par un second « E » pour Expérience (E-E-A-T). Ce ne sont pas des facteurs de classement codés explicitement, mais des critères guidant les évaluations de qualité. Google s'efforce d'aligner ses algorithmes sur ces principes, en récompensant les contenus expert, provenant de sources faisant autorité et dignes de confiance.

Pour en savoir plus sur les critères EEAT de Google, voir cet excellent article de l'expert Olaf Kopp publié dans le Search Engine Land en décembre 2024.

Les Core Updates (mises à jour générales de l'algorithme de Google, notamment celle surnommée Medic en 2018) ont souvent visé à affiner ces critères sur les pages, en particulier pour les sites YMYL (Your Money, Your Life - santé, finance, etc., où la barre de fiabilité est plus haute).

BERT (2019)

Modèle d'IA basé sur les réseaux de neurones (transformers) permettant de saisir le contexte des mots. BERT aide Google à comprendre le langage naturel, ce qui profite aux pages bien rédigées et contextuellement riches. Un contenu de qualité, rédigé de manière claire, bénéficie d'une meilleure compréhension par l'algorithme.

Mises à jour expérience-page (2020-2021)

Google a introduit des signaux d'expérience utilisateur dans le classement. Le Page Experience Update inclut des critères comme la navigation mobile (mobile-friendly), la sécurité HTTPS, l'absence d'interstitiels intrusifs, et les Core Web Vitals (indicateurs de performance web) mesurant la vitesse de chargement, l'interactivité et la stabilité visuelle.

Systèmes de classement basés sur l'IA (2021+)

Google a continué d'intégrer l'IA. Le modèle MUM (Multitask Unified Model), lancé en 2021, aide par exemple à répondre à des requêtes complexes en multi-langues et multimodal. En parallèle, Google a renforcé ses systèmes de détection de spam (SpamBrain) pour écarter les contenus trompeurs ou de faible qualité qui tentent de manipuler les résultats.

"Helpful Content" (2022)

Google a déployé le Helpful Content System (mise à jour dite du « contenu utile »), désormais intégré au cœur de l'algorithme. Ce système utilise un classifieur automatique pour détecter les sites dont le contenu est principalement créé pour les moteurs (contenu peu utile, généré de façon artificielle ou purement opportuniste) et les déclasse. L'objectif est de mettre en avant les contenus « écrits par des personnes pour des personnes » (people-first content).

Mises à jour dédiées aux avis produits (2021-2023)

Google a successivement amélioré la détection des avis de haute qualité. Les pages de critiques/produits qui offrent une analyse détaillée, des informations originales (tests terrain, photos, comparatifs) et démontrent l'expertise de l'auteur sont privilégiées. Le Reviews System récompense les avis approfondis et utiles, rédigés par des connaisseurs du sujet.

Remarque :

En 2025, l'algorithme de Google est donc capable d'évaluer la qualité sur plusieurs dimensions (contenu de la page, réputation du site, expérience utilisateur...) en s'appuyant sur des dizaines de signaux. A ce titre, Google a expliqué viser trois grands piliers : la pertinence vis-à-vis de la requête, la pertinence perçue pour l'utilisateur, et la qualité intrinsèque du contenu.

Signaux de qualité d'une page web (contenu et pertinence)

Du point de vue de Google, une page de haute qualité est une page qui répond pleinement au besoin de l'utilisateur, avec un contenu utile, fiable et agréable à consulter. Voici les principaux signaux de qualité on-page pris en compte :

Qualité intrinsèque du contenu

Le contenu doit être original, substantiel et informatif. Google valorise les pages qui apportent une valeur ajoutée par rapport aux autres résultats sur le même sujet. Un article doit idéalement couvrir son sujet en profondeur, apporter des informations uniques (recherches originales, analyse personnelle, cas pratiques) et répondre à différentes intentions de l'utilisateur. Les contenus trop courts, superficiels ou redondants sont considérés comme de faible qualité.

Expertise et exactitude du contenu

Un signal fort de qualité est la présence de connaissances expertes dans le texte. Google cherche à déterminer si l'article semble rédigé par quelqu'un qui maîtrise son sujet ou en a l'expérience directe. Un contenu de qualité doit être factuellement correct, sans erreurs flagrantes ni informations trompeuses. L'exactitude et la confiance qu'inspire le texte sont déterminantes. Les pages comportant de nombreuses erreurs factuelles ou approximations peuvent être déclassées pour faible fiabilité. Google pose par exemple la question : "Would you trust the information presented in this article ?". Ainsi, l'exactitude et la confiance qu'inspire le texte sont déterminantes.

E-E-A-T visible sur la page

La page elle-même devrait refléter l'Expérience, Expertise, Autorité et Fiabilité du contenu. Concrètement, la présence d'un auteur identifié avec une bio ou des qualifications pertinentes est un atout sur les pages YMYL ou spécialisées. Intégrer des éléments prouvant l'expérience vécue (photos originales, récit à la première personne, exemples concrets) renforce la qualité pour Google. Ces indices montrent que "le contenu provient d'une personne qui a concrètement expériementé ce dont elle parle", ce qui est particulièrement valorisé depuis 2022 comme le souligne Le Blog du Modérateur.

Couverture complète de la thématique

Une page de qualité traite son sujet de manière exhaustive et équilibrée. Google valorise le fait qu'un article explore les différentes facettes d'un sujet, éventuellement présente les deux côtés d'une histoire quand c'est pertinent, et répond aux questions connexes que pourrait se poser l'internaute. Par exemple, une bonne page de qualité sur un produit inclura non seulement ses caractéristiques, mais aussi ses avantages / inconvénients, des comparatifs, etc. Google dispose même d'un système d'évaluation des passages (Passage Ranking) capable d'identifier si une section précise de la page répond particulièrement bien à la requête de l'utilisateur.

Structure, clarté et rédaction

La manière dont le contenu est présenté compte également. Un contenu de qualité est généralement bien structuré (titres descriptifs, sous-sections logiques), bien écrit (grammaire et orthographe soignées) et agréable à lire. Des signaux comme l'absence de fautes ou le style professionnel indiquent un certain niveau d'édition et de sérieux. A l'inverse, un article "bâclé" ou mal formaté donne une impression de faible qualité. Le géant américain donne un exemple de questions à se poser dans ses critères : "Le contenu semble-t-il avoir été édité avec soin, ou paraît-il négligé ou produit à la va-vite ?". Une page bien présentée, avec des images pertinentes et une mise en forme lisible, retiendra mieux l'attention des utilisateurs.

Absence d'éléments gênants ou distrayants

La qualité d'une page peut être compromise par des éléments perturbant la lecture. Google pénalise les pages qui affichent une quantité excessive de publicités ou de pop-ups intrusifs masquant le contenu principal. Une page de haute qualité doit mettre en avant son contenu plutôt que de noyer l'utilisateur sous les annonces. De même, un design trop envahissant ou des interstitiels pleine page peuvent nuire à l'expérience utilisateur et donc à la perception de qualité (Google applique notamment un filtre spécifique aux interstitiels intrusifs sur mobile).

Références et liens externes

Lorsqu'une page traite d'un sujet en s'appuyant sur des sources, la qualité de ces sources compte. Citer ou faire des liens vers des sites faisant autorité (études, données officielles, articles d'experts) est un signal positif, car cela démontre un travail de recherche sérieux et « une connaissance du domaine ». A l'inverse, renvoyer vers des sites de faible qualité ou ne citer aucune source là où ce serait attendu (par exemple pour une statistique) peut entamer la confiance.

Actualité et fraîcheur du contenu

Pour certaines requêtes, en particulier dans l'actualité ou des domaines en évolution rapide, la fraîcheur est un critère de qualité. Google dispose de filtres de « Query Deserves Freshness » qui favorisent les contenus récents quand le contexte l'exige. Une page régulièrement mise à jour témoigne que le site entretient son contenu, ce qui est un bon signal. Selon certaines études, la fraîcheur des contenus serait par ailleurs particulièrement déterminante pour les LLM quand ils décident de s'appuyer sur telle ou telle source pour répondre à l'utilisateur.

Correspondance à l'intention de recherche

Même si la qualité intrinsèque est primordiale, une page n'est vraiment utile que si elle répond à ce que l'internaute cherchait. Google évalue donc dans quelle mesure le contenu correspond à l'intention de recherche visée. Une page peut être bien écrite mais hors-sujet par rapport à la requête (dans ce cas, elle sera jugée de faible utilité pour l'utilisateur. Au contraire, une page de qualité aligne son contenu sur les besoins de l'audience visée (par exemple, des explications pédagogiques pour les débutants ou des informations pointues pour les experts). La pertinence contextuelle fait ainsi partie de la qualité perçue.

Engagement utilisateur sur la page

Bien que Google ne communique pas ouvertement sur l'utilisation de métriques comportementales, les Google Leaks de mai 2024 ont montré à quel point l'engagement des utilisateurs était un indicateur de satisfaction déterminant dans le classement en Page 1 de Google. Avec Navboost, des paramètres comme le taux de clic (CTR) sur le résultat, le temps passé sur la page, le fait que l'utilisateur revienne ou non aux résultats, sont surveillés en permanence et permettent à Google d'ajuster ses pages de résultats suivant ces métriques. L'expérience utilisateur est en réalité le critère de classement numéro 1 pour Google. Vous pouvez avoir le meilleur contenu du monde, si votre page ne plaît pas aux internautes, vous ne serez jamais tout en haut des pages de résultats (ou que très temporairement).

Remarque :

Une page web de qualité aux yeux de Google est un contenu utile, riche, faisant autorité et plaisant aux utilisateurs. Le moteur détermine cela via une multitude de signaux combinés par ses algorithmes de classement. La priorité est donnée aux pages qui inspirent confiance (par leur expertise et transparence) et qui apportent une réelle valeur à l'internaute par rapport à la multitude d'autres pages indexées sur le même sujet. L'objectif de l'entreprise de Moutain View est de mettre en avant les pages faisant autorité et rétrograder les contenus de faible qualité.

Signaux de qualité d'un site web (évaluation globale)

Outre l'évaluation page par page, Google examine des signaux au niveau du site entier afin de juger de la fiabilité et de la qualité globale d'un domaine web. Ces signaux influencent le classement de l'ensemble des pages du site.

Réputation du domaine et autorité de la marque

Un site web de qualité est souvent reconnu par les utilisateurs et par les sources externes comme faisant autorité dans son domaine. Google prend en compte la notoriété de la marque ou du site : par exemple, le fait qu'il soit mentionné positivement dans des articles de presse, des forums spécialisés, des réseaux sociaux ou des discussions d'experts. Algorithmiquement, Google peut estimer la réputation via l'analyse des backlinks, des mentions de marque sans lien, et possiblement des données issues de Google Business Profile / avis tiers pour les entreprises locales.

Profil de backlinks du site (popularité)

Les liens entrants de qualité pointant vers un site constituent l'un des plus anciens signaux de confiance de Google. Un large nombre de backlinks provenant de sites fiables et variés indique que le contenu du site est apprécié et recommandé sur le web. Google utilise toujours le PageRank pour évaluer l'importance d'un site via ses liens, même s'il a évolué. L'algorithme en production actuellement est le Pagerank Nearest Seed. Ainsi, la proximité du site (en termes de nombre de clics) avec des "seed sites" de confiance dans le graphe du web (sites ayant la plus haute autorité pour une thématique donnée) est un atout majeur qui renforce sa propre fiabilité.

Cohérence et profondeur thématique

Google valorise les sites qui démontrent une expertise continue sur un sujet. Si un domaine publie régulièrement du contenu de qualité dans un secteur donné, il est peu à peu perçu comme référent sur ce thème. A l'inverse, un site qui traite de tout et de rien sans spécialisation aura du mal à être considéré comme faisant autorité. La cohérence thématique contribue à l'autorité du site.

Transparence et confiance du site

Un site web digne de confiance affiche clairement qui il est et d'où viennent ses contenus. La présence de pages institutionnelles (À propos, Contact, Mentions légales, Politique de confidentialité) est un prérequis pour inspirer confiance. Google y attache de l'importance : un site de qualité doit jouer la transparence sur son équipe éditoriale, ses auteurs, ses sources de financement éventuelles.

Fiabilité technique et sécurité du domaine

Sur le plan technique, certains éléments renvoient une image de sérieux ou non. Un site de qualité utilise HTTPS (chiffrement SSL) par défaut, garantissant la sécurité des données de l'utilisateur. Un site à jour, sans pop-ups abusifs ni publicités intrusives, renforce la confiance tant des utilisateurs que de Google.

Performances et expérience utilisateur globales

La qualité d'un site se voit aussi dans l'expérience cohérente qu'il offre à travers toutes ses pages. Un bon site aura une vitesse de chargement rapide sur desktop et mobile, une navigation mobile fluide, un design stable - autant d'éléments mesurés par les Core Web Vitals sur l'ensemble des pages.

Engagement et fidélité des utilisateurs

Un site de haute qualité a généralement une base d'utilisateurs fidèles ou satisfaits. Des signaux comme le trafic direct élevé (utilisateurs tapant l'URL ou ayant le site en favori) ou le nombre de recherches de la marque sur Google peuvent indiquer que le site a su gagner la confiance du public. De même, un taux de retour utilisateur élevé (les utilisateurs reviennent régulièrement sur le site) et une forte interaction (commentaires, partages sur les réseaux, etc.) traduisent une valeur perçue du site. Bien que difficiles à mesurer directement, ces tendances font écho à la notion d'autorité de marque que Google chercher à capter. Un site qui devient une référence verra naturellement ses pages mieux classées grâce à l'ensemble de ces apports (liens, trafic, recherche dédiées...)

Qualité globale du contenu du site

Google ne regarde pas qu'une page isolément, il considère aussi l'ensemble du contenu disponible sur le domaine. Un site peut comporter des pages excellentes et d'autres médiocres. Or, Google a averti que la présence de nombreuses pages de faible qualité peut pénaliser le classement du site entier. C'était l'essence du filtre Panda : un site avec des sections de contenu faible ou dupliqué verra même ses pages de qualité moins bien classées. Il est donc important, pour maintenir une haute qualité de site, de nettoyer (voir mon article sur le content pruning) ou améliorer les pages pauvres (supprimer ou enrichir le contenu très mince, fusionner les pages redondantes).

Un site web de qualité s'assure que chaque page apporte de la valeur et n'hésite pas à retirer le contenu obsolète ou inutile. De plus, un site sérieux évite les pratiques de spam sur ses pages (texte caché, sur-optimisation de mots-clés, etc.) sous peine de déclencher les filtres automatiques de Google qui détectent et pénalisent les comportements contraires aux consignes.

Conformité aux règles et absence d'abus

Enfin, la qualité d'un site se juge aussi à son respect des règles. Si un site fait l’objet de nombreux retraits de contenu pour raisons légales (par exemple violations de copyright via le DMCA, contenus diffamatoires ou contrefaçons), Google applique des pénalités algorithmiques sur l’ensemble du site.

Signaux d'expérience utilisateur et qualités techniques

Nous l'avons vu, la qualité perçue d'une page ou d'un site est également fortement influencée par l'expérience utilisateur offerte. Google intègre plusieurs signaux techniques dans son évaluation, partant du principe qu'un contenu excellent peut être gâché par une mauvaise expérience de navigation. Voici les points à considérer :

Performances de chargement (Core Web Vitals)

Google mesure trois indicateurs Web Vitals qui capturent des aspects essentiels de l'UX : le Largest Contentful Paint (LCP) pour la vitesse de chargement, le Interaction to Next Paint (INP) pour la réactivité aux interactions, et le Cumulative Layout Shift (CLS) pour la stabilité visuelle (éviter que la mise en page bouge pendant le chargement). Des scores élevés signifient que la page est rapide et stable, ce qui est un signal de qualité. Google a fait du respect de ces seuils de Core Web Vitals un critère de classement (modéré) depuis 2021, sous le terme Page Experience. En pratique, un site rapide et fluide retient mieux ses visiteurs et est donc mieux noté qu'un site lent où l'utilisateur s'impatiente, ce qui arrive plus souvent qu'on le croit sur mobile.

Compatibilité mobile (Mobile-Friendly)

Depuis plusieurs années, Google utilise l'indexation mobile-first, ce qui signifie qu'il évalue en priorité la version mobile des pages. Un site non optimisé pour mobile (texte illisible sans zoom, éléments cliquables trop petits, défilements horizontaux, etc.) sera dévalorisé sur les recherches mobiles. Google a même lancé en 2015 une mise à jour dédiée (Mobilegeddon) pour favoriser les sites mobile-friendly. En 2025, c'est un prérequis : une page de qualité doit l'être autant sur mobile que sur desktop, sans quoi son classement global en souffrira.

Design et lisibilité

Bien qu'indirect, le design d'une page joue sur la qualité perçue. Une interface épurée, une navigation intuitive, des polices lisibles, tout cela améliore l'expérience. Google peut capter en partie ce facteur via le comportement utilisateur (une page confuse pourrait augmenter le taux de rebond). Il existe aussi un algorithme Page Layout (2012) qui pénalise les pages ayant trop peu de contenu visible au-dessus de la ligne de flottaison (par exemple un écran saturé de bannières) au chargement. Une page de haute qualité doit donc afficher rapidement son contenu principal sans obliger l’utilisateur à scroller après une forêt de pubs .

Intrusion publicitaire maîtrisée

Prolongement du point précédent, Google a déclaré la guerre aux interstitiels intrusifs et autres pop-ups agressifs. Depuis 2017, un site mobile qui affiche immédiatement une pop-up couvrant tout l'écran peut être pénalisé. C'est un signal négatif de qualité car cela frustre l'utilisateur. De même, les sites abusant de techniques d’engagement forcé (lecteurs vidéo auto-play avec son, fenêtres modales difficiles à fermer) risquent d’être perçus comme moins qualitatifs. En revanche, des appels modérés (une bannière discrète, un formulaire bien intégré) n’affecteront pas la qualité si le contenu reste facilement accessible. L'objectif pour Google est de favoriser les sites qui respectent l'expérience utilisateur.

Sécurité et confidentialité

L'usage du HTTPS est désormais la norme et Google l'a intégré comme un signe de confiance. Un site en HTTP non sécurisé sera marqué "Non sécurisé" par les navigateurs, ce qui nuit à sa crédibilité. Par ailleurs, un site de qualité offre des garanties de confidentialité (par exemple, une politique RGPD, un paramétrage des cookies non bloquant). Ce ne sont pas des facteurs de classement directs, mais ils contribuent à la confiance globale envers le site, donc à son image de qualité.

Absence d'erreurs techniques

Un bon site se caractérise aussi par un fonctionnement technique sans accroc. Des liens cassés en pagaille, des erreurs 404 non gérées, un certificat SSL expiré ou un temps de réponse du serveur très long sont autant de signaux que le site n'est pas bien maintenu. Google peut détecter un taux inhabituel d’erreurs de crawl ou de downtime, ce qui affecte l’indexation et potentiellement le classement. Un site de qualité surveille sa Search Console et est crawlé régulièrement pour corriger les erreurs et s'assurer que les internautes (et Googlebot) naviguent sans rencontrer d’impasses.

Optimisation sémantique et données structurées

Si une page fournit un bon contenu, l'utilisation de données structurées (Schema) appropriées peut enrichir sa présentation dans les résultats (extraits enrichis, étoiles d'avis, FAQ déployée, etc.), améliorant le taux de clic et donc, indirectement, le signal de satisfaction.

Remarque :

L’expérience utilisateur offerte est un prolongement de la qualité. Google veut éviter de proposer à ses utilisateurs des pages au contenu certes pertinent, mais difficiles ou désagréables à utiliser. Tous ces signaux UX et techniques sont donc intégrés, à des degrés divers, dans l’évaluation globale d’une page et d’un site. Ils servent souvent de facteur de différenciation : si deux pages ont un contenu de qualité comparable, celle offrant la meilleure expérience (plus rapide, plus mobile-friendly, plus sûre) aura l’avantage . À l’ère de l’instantanéité, la qualité perçue est indissociable de la qualité

d’usage.

En 2025, la notion de qualité pour Google repose sur un large ensemble de signaux recoupant le contenu, la réputation et l'expérience utilisateur. Pour qu'une page web soit jugée de qualité, elle doit apporter une information fiable, originale et utile, démontrer de l'expertise, inspirer confiance, tout en étant techniquement au point et agréable à consulter.

De même, pour qu'un site web dans son ensemble soit considéré de haute qualité, il doit prouver sur la durée sa crédibilité (par ses liens, sa transparence, ses avis positifs), maintenir une cohérence éditoriale exemplaire et offrir aux visiteurs une expérience sans friction.

Google combine des algorithmes comme Panda (qualité de contenu), Penguin (qualité des liens), le Helpful Content system (utilité pour l'utilisateur), les Page Experience signals (UX) et d'autres, afin de mesurer ces différents aspects de la qualité et de classer les résultats en conséquence.

En suivant les recommandations de Google sur les sites de haute qualité - "focus on delivering the best possible user experience" plutôt que de chercher des astuces - les éditeurs maximisent leurs chances de voir leur site considéré comme qualitativement fiable et donc bien positionné dans la recherche. Les critères évoluent, mais le but reste constant : proposer aux utilisateurs les résultats les plus utiles, pertinents et dignes de confiance.

Commentaires

Aucun commentaire pour le moment. Soyez le premier à commenter !

Ajouter un commentaire