Qu'est-ce q'une hallucination en IA ?

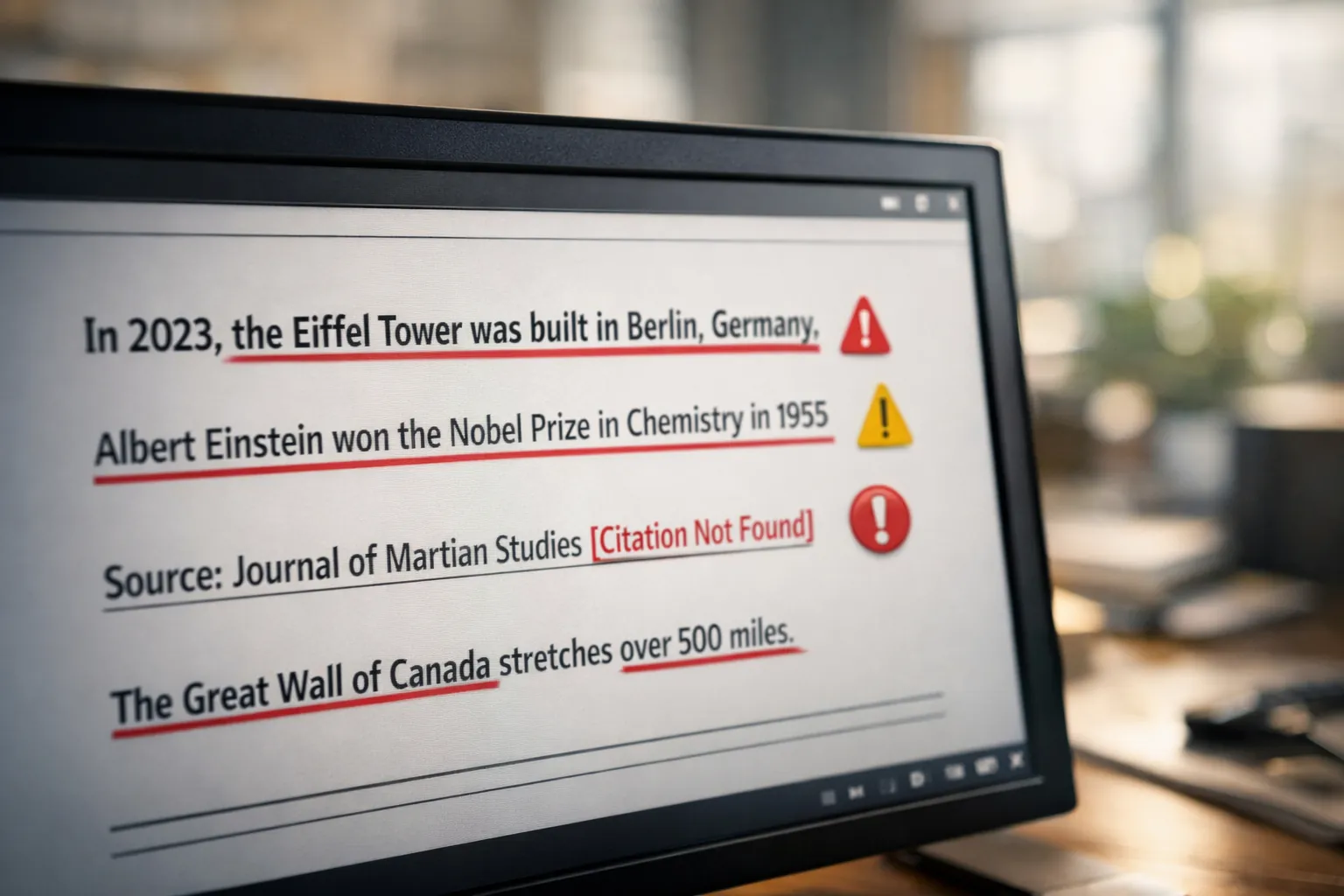

Une hallucination en intelligence artificielle désigne une réponse générée par un grand modèle de langage qui paraît cohérente et plausible, mais qui ne correspond à aucune réalité factuelle. Le chatbot ou l'assistant génératif produit alors une information erronée, invente une citation, fabrique une source bibliographique ou attribue des propos à une personne qui ne les a jamais tenus. Contrairement à une simple erreur ponctuelle, l'hallucination se caractérise par la confiance avec laquelle le modèle affirme quelque chose de faux.

Dans le contexte SEO, cela pose un problème immédiat : si vous publiez un contenu généré par ChatGPT, Gemini ou tout autre LLM sans vérification, vous risquez de diffuser des informations inexactes qui dégraderont votre autorité thématique auprès de Google et surtout auprès de vos lecteurs. Un article bourré d'erreurs factuelles perdra rapidement en crédibilité, générera des signaux utilisateurs négatifs (taux de rebond élevé, faible temps de lecture), sera rapidement dégradé dans les pages de résultats du moteur de recherche, et ne sera ni partagé ni cité par d'autres sites de qualité.

Pourquoi les modèles génératifs hallucinent

Comprendre les mécanismes qui provoquent les hallucinations permet de mieux anticiper le risque. Les modèles de langage comme GPT d'OpenAI ou Google Gemini fonctionnent sur un principe de prédiction probabiliste : ils génèrent du texte token par token, en choisissant à chaque étape parmi un échantillon le mot le plus probable selon les données d'entraînement. Ce processus n'implique aucune vérification factuelle en temps réel, aucune consultation d'une base de connaissances externe, et aucun ancrage (grounding) dans le monde réel.

Plusieurs facteurs expliquent l'apparition d'hallucinations. Tout d'abord, les données d'entraînement sont susceptibles de contenir des informations contradictoires, obsolètes ou carrément fausses : le modèle a alors ingéré des millions de pages web dont certaines propagent des rumeurs ou des approximations.

Ensuite, le modèle généralise à partir de patterns linguistiques sans toujours distinguer ce qui relève de la fiction, de l'opinion ou du fait avéré.

Enfin, lorsqu’il est confronté à une question pour laquelle il ne dispose pas d’informations suffisantes, un modèle de langage n’a pas de mécanisme natif lui permettant d’exprimer son ignorance. Entraîné par apprentissage supervisé puis par renforcement humain (Reinforcement Learning from Human Feedback) à produire des réponses complètes, fluides et perçues comme utiles, il tend à générer une réponse plausible plutôt qu’à s’abstenir, même lorsque cette réponse repose sur des hypothèses implicites ou des extrapolations erronées.

Exemples concrets d'hallucinations qui nuisent au SEO

Prenons trois cas fréquents qui illustrent le danger pour votre stratégie de contenu.

Exemple 1 : Citation juridique inventée. Un avocat américain a soumis un mémoire rédigé avec l'aide de ChatGPT, qui citait six décisions de justice totalement fictives. Le tribunal a sanctionné l'avocat pour avoir présenté des sources inexistantes. Dans un contexte SEO, imaginez publier un article de blog citant une étude scientifique ou un rapport d'expert qui n'existe pas : dès qu'un lecteur avisé vérifie vos sources, votre crédibilité s'effondre.

Exemple 2 : Données chiffrées erronées. Vous demandez à un modèle génératif de produire un article sur le marché du e-commerce en France. Il affirme que "le chiffre d'affaires du secteur a atteint 180 milliards d'euros en 2023" alors que le chiffre réel est différent. Google valorise de plus en plus l'exactitude factuelle (notamment via les mises à jour EEAT), et publier des statistiques fausses vous expose à une perte de confiance de la part des utilisateurs et des moteurs de recherche.

Exemple 3 : Informations contradictoires sur un produit. Un site e-commerce génère automatiquement des fiches produits avec une IA. Le modèle invente une caractéristique technique inexistante ou confond deux références. Le client commande, reçoit un produit différent de la description, et laisse un avis négatif. Résultat : baisse du taux de conversion, augmentation du taux de retour, et dégradation du score qualité sur Google Shopping.

Les risques pour votre stratégie de contenu et votre référencement

Les hallucinations d'IA ne sont pas qu'un problème théorique : elles ont des conséquences directes sur votre visibilité organique et votre autorité thématique.

D'abord, Google accorde une importance croissante aux signaux EEAT (Experience, Expertise, Authoritativeness, Trustworthiness). Un contenu truffé d'erreurs factuelles sera perçu comme peu fiable, ce qui peut entraîner une perte de positionnement sur vos requêtes stratégiques. Ensuite, les utilisateurs qui repèrent des inexactitudes quittent rapidement la page, augmentant votre taux de rebond et réduisant le temps moyen sur site, deux métriques que Google surveille via Navboost pour évaluer la qualité d'une page.

Enfin, si d'autres sites commencent à pointer du doigt vos erreurs ou si des experts de votre secteur vous critiquent publiquement, vous risquez de perdre des backlinks naturels et de voir votre réputation en ligne détériorée. Dans un environnement où la confiance est un actif majeur pour le SEO, publier du contenu halluciné revient à scier la branche sur laquelle vous êtes assis.

Comment réduire les hallucinations avec des techniques de prompting avancées

La première ligne de défense contre les hallucinations consiste à mieux guider le modèle génératif dès la phase de prompt. Plutôt que de poser une question ouverte comme "Rédige un article sur l'IA et le SEO", vous devez structurer votre demande pour forcer le modèle à adopter une posture plus rigoureuse.

Commencez par demander explicitement au modèle de citer ses sources : "Écris un paragraphe sur l'impact de l'IA sur le référencement naturel, et indique entre crochets les sources ou études que tu mentionnes." En obligeant le LLM à justifier ses affirmations, vous réduisez le risque qu'il invente des données. Si le modèle ne peut pas fournir de source, il sera plus enclin à admettre son incertitude ou à formuler une réponse plus prudente.

Ensuite, imposez des contraintes de format et de contenu : "Utilise uniquement des informations vérifiables et évite toute affirmation définitive si tu n'as pas de source fiable." Vous pouvez également demander au modèle de signaler explicitement les zones d'incertitude : "Indique clairement quand tu fais une hypothèse ou quand tu manques de données récentes."

Enfin, une technique particulièrement efficace consiste à utiliser la méthode Chain-of-Verification (CoVe), proposée par Meta AI Research. Cette approche en plusieurs étapes demande au modèle de générer une réponse initiale, puis de produire une liste de questions de vérification sur cette réponse, d'y répondre indépendamment, et enfin de corriger la réponse initiale en fonction des vérifications. Concrètement, vous pouvez décomposer votre workflow en trois prompts successifs : générer un draft, vérifier chaque affirmation clé, puis produire une version finale corrigée. Cette méthode réduit significativement le taux d'hallucination en introduisant une boucle de contrôle interne.

Je vous propose par ailleurs mon GPT personnalisé sobrement intitulé Fact Checker qui permet, en lui soumettant une URL ou un texte, d'obtenir une vérification factuelle complète de toutes les informations factuelles identifiées dans le contenu. Seules les informations validées par 3 sources différentes obtiennent le statut "Confirmé".

L'apport du RAG pour ancrer vos contenus dans des sources fiables

Le Retrieval-Augmented Generation (RAG) représente une solution technique puissante pour limiter les hallucinations. Le principe consiste à ne pas laisser le modèle générer du contenu uniquement à partir de sa mémoire d'entraînement, mais à lui fournir en temps réel des documents sources pertinents qu'il doit utiliser pour construire sa réponse.

Dans un contexte SEO, cela signifie que vous pouvez alimenter votre pipeline de génération de contenu avec vos propres bases de données internes, vos articles de blog existants, vos études de cas, ou des sources externes fiables (rapports officiels, publications académiques, données de marché certifiées). Le modèle génératif va alors s'appuyer sur ces documents pour produire du texte, réduisant ainsi la probabilité d'inventer des informations.

Attention cependant : le RAG n'est pas une solution miracle. Si les documents sources contiennent eux-mêmes des erreurs ou sont obsolètes, le modèle reproduira ces inexactitudes. Il reste donc indispensable de maintenir une base documentaire de qualité et à jour, et de vérifier régulièrement la pertinence des sources injectées dans le système.

Mettre en place des garde-fous opérationnels

Au-delà des techniques de prompting et du RAG, vous devez structurer un processus de production qui intègre des points de contrôle humains et automatisés.

Premièrement, ne publiez jamais un contenu généré par IA sans relecture humaine. Un rédacteur ou un expert métier doit systématiquement vérifier les affirmations factuelles, les chiffres, les citations et les sources mentionnées. Cette étape de validation humaine reste le meilleur rempart contre les erreurs grossières.

Deuxièmement, implémentez des règles automatiques qui détectent les signaux d'alerte. Par exemple, si votre contenu mentionne une étude ou un rapport, un script peut vérifier automatiquement si le lien ou la référence existe réellement. Si une date est citée, vous pouvez valider qu'elle est cohérente avec le contexte. Si un nom propre apparaît, un outil peut vérifier qu'il s'agit bien d'une personne ou d'une organisation réelle.

Troisièmement, définissez des seuils de tolérance et des scores de confiance. Certains modèles génératifs permettent d'obtenir un score de confiance pour chaque réponse. Si le score est faible, vous pouvez décider de ne pas utiliser ce contenu ou de le soumettre à une vérification renforcée. Vous pouvez également segmenter vos contenus selon leur criticité : un article de blog informatif tolère un risque plus élevé qu'une fiche produit ou un guide technique destiné à des professionnels.

Comment détecter et mesurer le problème en production

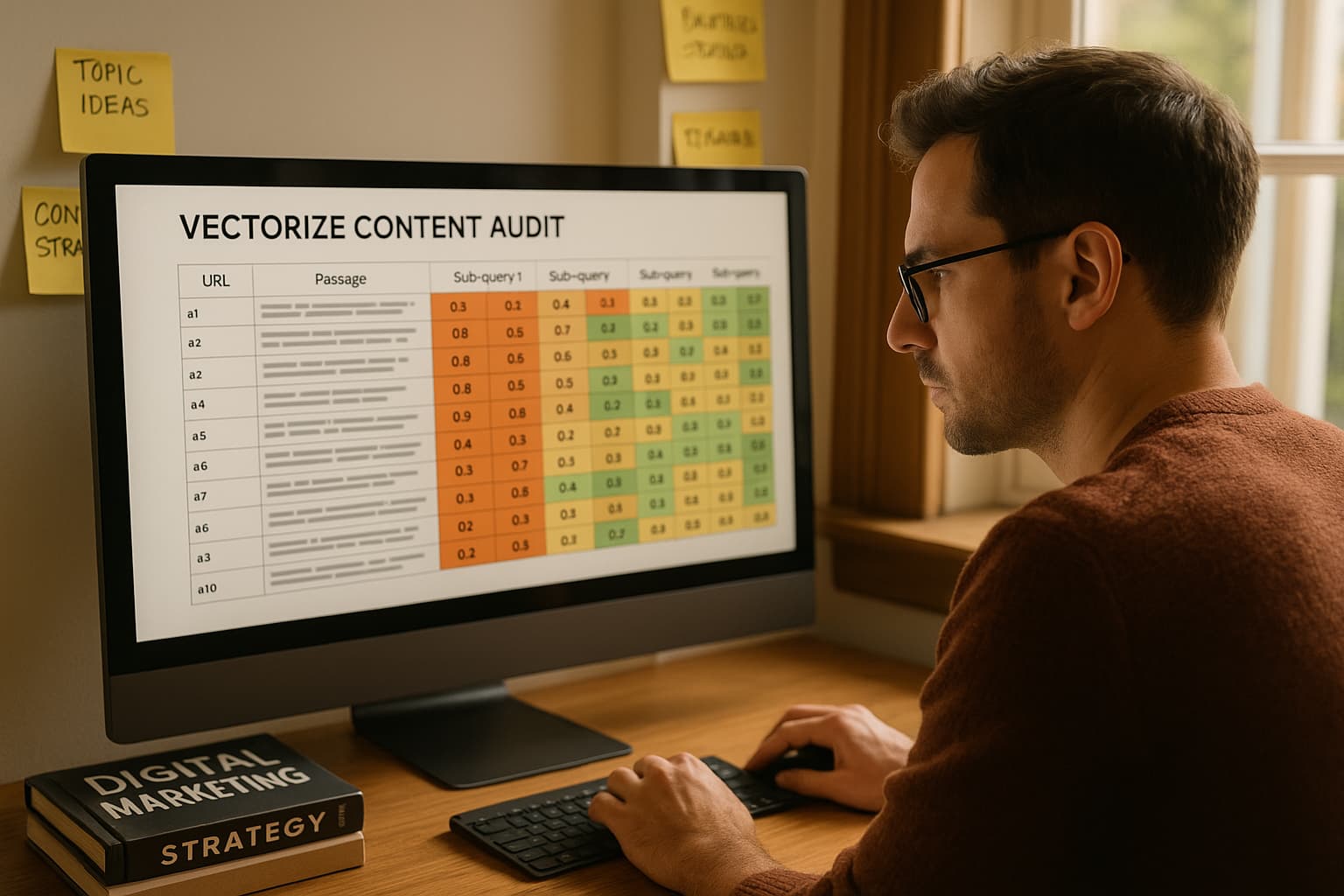

Pour piloter la qualité de vos contenus générés, vous devez mettre en place un dispositif de mesure et de monitoring. Cela commence par constituer un jeu de test : une liste de questions ou de sujets pour lesquels vous connaissez les bonnes réponses. Vous soumettez régulièrement ces tests à votre système de génération de contenu et vous évaluez le taux d'exactitude des réponses produites.

Ensuite, vous pouvez déployer un échantillonnage aléatoire en production. Par exemple, chaque semaine, vous prélevez 10 articles générés et vous les faites auditer manuellement par un expert. Vous relevez le nombre d'erreurs factuelles, de citations inexistantes, et d'informations contradictoires. Ces données vous permettent de calculer un taux d'hallucination moyen et de suivre son évolution dans le temps.

Enfin, surveillez les retours utilisateurs et les métriques comportementales. Si vous constatez une hausse du taux de rebond sur des pages générées par IA, ou si des commentaires négatifs signalent des erreurs, c'est un signal d'alerte qui doit déclencher un audit approfondi. Google Analytics, la Search Console et les outils de feedback utilisateur deviennent ainsi des alliés précieux pour identifier les contenus problématiques avant qu'ils ne nuisent durablement à votre référencement.

Ce qu'il faut retenir pour protéger votre SEO

Les hallucinations d'IA ne sont pas une fatalité, mais elles exigent une vigilance constante et des processus de contrôle rigoureux. Si vous utilisez des modèles génératifs pour produire du contenu SEO, vous devez structurer votre workflow autour de quatre piliers : un prompting exigeant qui force le modèle à justifier ses affirmations, l'utilisation de techniques comme le Chain-of-Verification et le RAG pour ancrer les réponses dans des sources fiables, la mise en place de garde-fous automatiques et de validations humaines, et enfin un monitoring continu pour détecter et corriger rapidement les dérives.

Dans un environnement où Google valorise de plus en plus la fiabilité et l'expertise des contenus, négliger le risque d'hallucination revient à compromettre votre autorité thématique et votre visibilité organique. La bonne nouvelle, c'est que les outils et les méthodologies existent pour limiter drastiquement ce risque, à condition de les intégrer dès la conception de votre stratégie de production de contenu.

Commentaires

Aucun commentaire pour le moment. Soyez le premier à commenter !

Ajouter un commentaire