Pourquoi remettre en question les outils actuels de "visibilité IA" ?

Le problème de la reconstitution des prompts

De nombreux outils fleurissent depuis plusieurs mois promettant d'évaluer votre présence dans les moteurs de recherche génératifs. Pour y parvenir, ils tentent de reconstituer des prompts utilisateurs liés à votre thématique. Les plus perfectionnés définissent au préalable des personae afin d'être au plus proche des besoins des consommateurs du client qui s'abonne à l'outil, afin de pré-générer des prompts par segment d'utilisateurs.

Cette approche présente à mes yeux une faille majeure : l'absence totale de données réelles sur les invites effectivement saisies par les utilisateurs dans ChatGPT ou d'autres plateformes conversationnelles. Même si l'effort est louable (vu l'engouement autour du sujet, il faut bien présenter des données au CODIR), ces outils inventent littéralement des prompts, créant une fiction analytique sans fondement scientifique. Le risque est de vous épuiser à optimiser des contenus pour des requêtes hypothétiques qui ne correspondent pas aux comportements réels des utilisateurs.

Cas concret : comment être référencé sur ChatGPT

L'écart entre visibilité IA théorique et réalité

Un indicateur ne trompe pas : si un outil vous affirme être visible sur certains prompts, mais que vos données réelles issues de vos logs serveur ou d'un outil analytique comme Google Analytics 4 montrent que :

- Les chatbots ne visitent pas vos contenus,

- Les utilisateurs ne proviennent pas de ces moteurs IA,

Il existe un décalage fondamental entre les prédictions de l'outil et la réalité du terrain.

Une méthodologie d'analyse de la visibilité IA basée sur les données réelles

La bonne nouvelle est que les moteurs IA disposent de leurs propres crawlers, identifiables dans les logs serveur :

- OAI-SearchBot et ChatGPT-User pour OpenAI (ChatGPT) ;

- PerplexityBot et Perplexity-User pour Perplexity.ai ;

- ClaudeSearchBot et Claude-User pour Anthropic.

Une liste des bots IA est accessible en cilquant sur ce lien.

L'analyse de ces logs permet d'identifier les pages effectivement explorées par ces bots, et donc de repérer les contenus qui intéressent déjà les IA dans leur processus d'entraînement ou de recherche contextuelle.

C'est à partir de ces contenus qui sont déjà explorées par les moteurs conversationnels lorsqu'ils effectuent une recherche en temps réel pour répondre à un prompt utilisateur, que je vous propose de démarrer votre analyse de visibilité. Mais enrichissons-la des données issues d'un outil d'analytics tels que GA4.

Observer les utilisateurs en provenance des moteurs IA dans GA4

Dans Google Analytics 4, il est possible de repérer les sessions provenant directement de ChatGPT, Perplexity, Claude ou tout autre moteur génératif, en analysant :

- le champ referrer ;

- la source de session (session_source) ;

- ou encore certains schémas d'URL caractéristiques (le fameux "?utm_source=chatgpt.com" collés à la fin de toutes les URLs recensées par ChatGPT).

Un tutoriel vous permettant de paramétrer GA4 pour suivre votre trafic IA est accessible en cliquant sur ce lien.

En combinant les logs serveurs avec les données GA4, on peut commencer à distinguer :

- Les contenus explorés par les IA ;

- Ceux consultés par des utilisateurs en provenance des plateformes IA ;

- Ceux qui sont totalement ignorés ;

- Ceux qui sont explorés par les IA mais qui n'apportent aucun trafic (ce qui veut potentiellement dire qu'ils ne sont jamais mis en avant dans la réponse synthétique du chatbot).

Ces premières données constituent la base du cadre d'analyse empirique proposé.

En savoir plus sur l'analyse de logs SEO à l'ère de l'IA

Reconstituer des scénarios de prompts à partir des données de la Search Console (Google et Bing)

L'idée du "reverse prompting"

A partir des contenus visités par les bots IA, je vous propose d'observer les requêtes Google et/ou Bing associées à ces pages. L'hypothèse explorée ici est que certaines requêtes pourraient être le résultat de sous-requêtes générées par des moteurs IA à partir d'un prompt utilisateur suite à un processus de query fanout.

Nous savons en effet que ces nouveaux outils interrogent les moteurs de recherche classiques lorsqu'ils estiment avoir besoin de plus de connaissances que celles acquises au cours de leur entraînement pour répondre à un prompt utilisateur. Nous savons notamment que ChatGPT utilise un service tiers nommé SerpAPI pour interroger l'index de Google, et qu'il s'agit sans doute de la raison pour laquelle le géant américain a rendu dernièrement le scraping de ses pages de résultats beaucoup plus difficile avec la disparition du paramètre "&num=100" en octobre 2025. Nous supposons très fortement que ChatGPT continue à scraper Google (mais seulement les premières pages car sinon cela lui coûterait beaucoup plus cher qu'auparavant) et qu'il le fait en parallèle (ou en complètement) avec le scraping des pages de résultats de Bing.

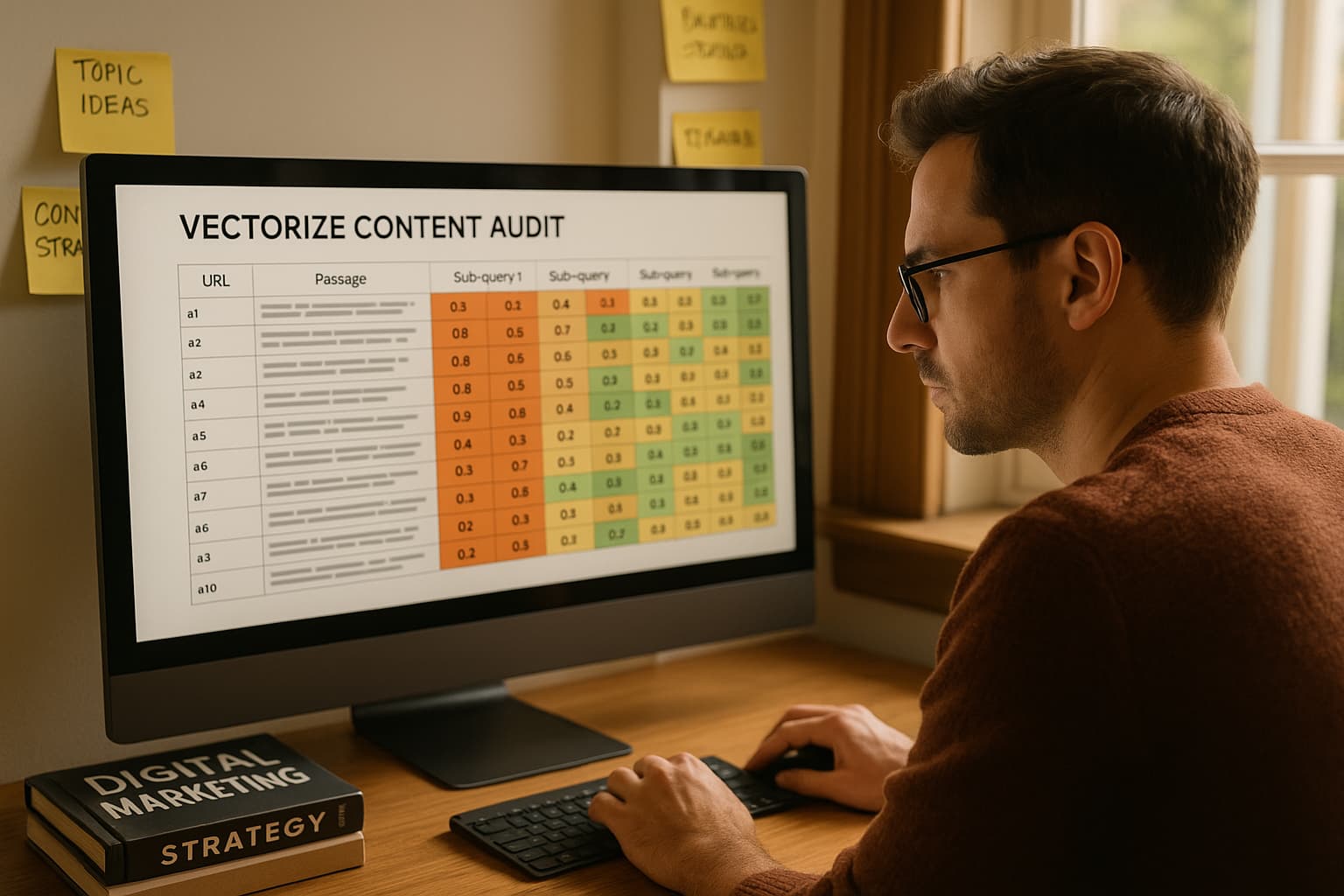

L'idée est donc ici d'identifier les requêtes affichées dans la Google Search Console et/ou dans la Bing Search Console sur lesquelles vos pages qui sont visitées par les bots IA se positionnent avec une position moyenne égale ou inférieure à 10 (ou 20 si on veut plus de données).

Peut-on identifier parmi ces requêtes celles qui sont générées automatiquement par ChatGPT et consorts ? Non, même si certains patterns des queries fan out issus du moteur d'OpenAI peuvent être observés :

- syntaxe inversée ("IA SEO comment mesurer visibilité") ;

- absence de stopwords ("comment IA choisit contenu") ;

- précision extrême sur un point de détail ("détailler méthode logs IA SEO").

En clair, les moteurs de recherche génératifs génèrent plutôt des requêtes de longue traîne, précises et contextualisés, et s'intéressent au contraire très peu aux requêtes génériques. Cela s'explique d'ailleurs fort bien si on comprend que l'objectif ultime de ces nouvelles plateformes est de fournir la meilleure réponse possible à l'utilisateur, donc la plus précise, c'est-à-dire celle qui sera la plus à même de satisfaire son besoin. Mieux vaut cibler des documents qui répondent à des besoins précis plutôt que de cibler des documents génériques.

Quoi qu'il en soit, ce que je propose est de récupérer parmi ces requêtes celles qui paraissent les plus intéressantes (un nettoyage est souvent nécessaire car un contenu se positionne souvent sur des requêtes improbables) et de tenter, à partir de là, de reconstituer un ou plusieurs prompts d'origine dans ChatGPT.

Je me suis d'ailleurs amusé à construire un GPT personnalisé de reconstitution d'un prompt utilisateur à partir d'un éventail de requêtes pour l'exercice.

Reconstitution d'un prompt utilisateur à partir de sous-requêtes générées par ChatGPT

En reconstituant un prompt utilisateur à partir de sous-requêtes, puis en tapant ce prompt dans ChatGPT pour observer le fanout réellement généré (ce qu'on peut faire facilement aujourd'hui grâce à des plugins développés par la communauté), on peut savoir si on tombe juste ou pas en termes de requêtes générées par la machine et de sources récupérées, et ajuster en conséquence. L'idée étant bien-sûr de taper un prompt qui permet à ChatGPT de récupérer la page dont vous avez observé au préalable qu'elle était visitée par le moteur IA.

Analyse concurrentielle et Gap analysis

Une fois que vous êtes arrivé à votre objectif, il est particulièrement intéressant de taper vous-mêmes les sous-requêtes réellement générées par l'IA dans Google ou dans Bing. Pour chacune d'entre elles, vérifiez si vous êtes réellement visibles dans les moteurs de recherche classiques, et à quelle position. Et identifiez quels sont les concurrents qui sont mieux positionnés que vous sur ces requêtes de niche.

ChatGPT, comme les autres moteurs génératifs, utilisent après le fanout un mécanisme de Reciprocal Rank Fusion (RFF) afin de fusionner les différents classements récupérés et identifier quels sont les documents réellement pertinents pour répondre à l'utilisateur. Nous pouvons expliquer ce fonctionnement par le fait que l'outil d'OpenAI va s'appuyer en priorité sur les documents qui se positionnent le mieux en moyenne sur l'ensemble des sous-requêtes générées à partir du prompt original de l'utilisateur. Tout simplement parce que ChatGPT présuppose que les documents qui ont la position moyenne la plus haute sur l'ensemble des queries fanout sont ceux qui répondent le mieux à l'ensemble des besoins de l'utilisateur.

Votre objectif doit donc être, dans le cadre du Generative Engine Optimization (GEO), c'est-à-dire de l'optimisation de votre visibilité dans les moteurs IA, de vous classer le plus haut possible sur l'ensemble des sous-requêtes générées automatiquement, et non pas (ou plutôt, pas seulement) sur la requête la plus générique de votre sujet cible. Les deux objectifs ne sont pas contradictoires évidemment, surtout si Google fait bien son travail, il est censé mettre en avant sur les requêtes les plus génériques les contenus qui répondent le mieux et le plus précisément possible à l'ensemble des sous-besoins exprimés par un internaute sous la forme d'une requête. Mais cette vérification de votre positionnement sur l'ensemble des sous-requêtes liés à votre mot-clé principal me paraît être un incontournable dans le cadre du GEO, tout simplement parce que c'est comme cela que les moteurs IA fonctionnent.

Une fois cette analyse de votre classement sur les sous-requêtes effectuées, comment optimiser vos contenus ? Je vous propose d'identifier le ou les contenus concurrents qui se positionnent mieux que vous sur ces sous-requêtes, et d'adopter ce mécanisme de génération d'un fanout à partir de ce(s) document(s).

Je me suis, encore une fois, amusé à créer un GPT personnalisé pour générer un fanout de requêtes à partir d'un contenu. N'hésitez pas à tester.

Génération d'un fanout de requêtes à partir d'un document textuel

Je m'appuie sur un brevet des équipes de Google datant de 2023 pour vous dire ça. Ce brevet explique qu'ils entraînent un modèle de machine learning à générer un fanout à partir d'un document afin d'améliorer la récupération des bonnes informations liées à ce document. L'idée consiste à faire en sorte d'augmenter la probabilité de récupérer le bon passage du document à partir d'une requête générée. Pour y arriver, il est donc nécessaire que la requête soit la plus précise et contextualisée possible.

En adoptant ce même mécanisme, vous identifiez tous les sous-sujets abordés dans le contenu de votre concurrent principal. Et vous pouvez réitérer l'exercice sur votre propre contenu afin d'identifier quels sont les angles morts, c'est-à-dire les sujets que vous n'évoquez pas dans votre page web et qui la rend moins complète que celle de vos concurrents. En comblant ces gaps, vous approfondissez votre sujet dans les moindres détails et vous augmentez vos chances d'être bien positionnés sur le fanout généré par les moteurs IA, donc d'être sélectionné comme le document référent par rapport au prompt de l'utilisateur, donc d'être mis en avant dans la réponse.

Plan d'action opérationnel de l'optimisation de la visibilité dans les moteurs IA

Phase 1 : Diagnostic

- Analyser les logs serveur pour identifier le crawl des bots IA

- Configurer le tracking GA4 pour le trafic en provenance des moteurs IA

Phase 2 : Analyse

- Croiser les données logs serveur et GA4

- Segmenter les contenus crawlés par les bots IA mais qui ne vous apportent pas de trafic des contenus déjà performants

- Extraire les requêtes précises et contextualisées de la Search Console (Google et Bing) sur lesquelles votre position moyenne est inférieure à 10 ou 20

- Reconstituer les prompts d'origine à partir de ces sous-requêtes afin d'identifier les vraies questions qui déclenchent un crawl IA de vos contenus

- Relever votre position sur chacune des sous-requêtes générée par l'IA ainsi que celles des concurrents qui sont mieux classés

Phase 3 : Optimisation

- identifier les angles morts de vos contenus par rapport aux concurrents qui sont meilleurs sur les requêtes fanout

- Développer la couverture longue traîne de vos contenus crawlés par les moteurs IA mais qui vous apportent pas ou peu de trafic

- Améliorer la profondeur sémantique de vos contenus éligibles à la visibilité IA

Phase 4 : Monitoring

- Suivre l'évolution du crawl IA

- Suivre l'évolution du trafic utilisateur en provenonce des plateformes génératives

- Ajuster la stratégie

Une démarche d'analyse ouverte et évolutive

L'optimisation pour les moteurs IA exige à mes yeux une rupture méthodologique : abandonner les approches spéculatives basées sur des prompts inventés au profit d'une analyse rigoureuse des données réelles. L'approche proposé ne constitue évidemment pas un modèle définitif, mais une proposition de cadre analytique pour observer la visibilité dans les moteurs IA à partir de données vérifiables, et d'optimiser vos contenus en conséquence. Elle demande à être testée, enrichie et discutée par la communauté SEO et data.

N'hésitez pas à me faire part de vos observations dans les commentaires afin que nous progressions ensemble dans l'écosystème émergent de la recherche conversationnelle.

Commentaires

Aucun commentaire pour le moment. Soyez le premier à commenter !

Ajouter un commentaire