L’analyse de logs SEO a toujours été un pilier du référencement technique. Mais depuis l’explosion des intelligences artificielles conversationnelles (ChatGPT, Perplexity, Claude, etc.), cette pratique prend une dimension totalement nouvelle. Le web n’est plus seulement exploré par Googlebot et Bingbot : des bots IA aux comportements inédits parcourent désormais les sites pour nourrir les modèles de langage (LLM), construire de nouveaux index de rercherche ou répondre aux utilisateurs en temps réel.

Comprendre comment ces nouveaux bots interagissent avec votre site est donc essentiel pour protéger vos ressources, optimiser vos contenus et saisir les opportunités de visibilité offertes par ces plateformes émergentes.

Pourquoi l’analyse de logs est plus stratégique que jamais en 2025 ?

Les fichiers de logs enregistrent chaque requête effectuée sur votre serveur. Ils révèlent notamment quelles pages sont visitées, à quelle fréquence, par quels bots, et avec quels codes de réponse HTTP. En SEO, les experts techniques se concentrent depuis toujours sur l’analyse du comportement de Googlebot, afin d’identifier par exemple les goulots d’étranglement, les erreurs 404 trop fréquentes, ou encore les zones inexplorées par les robots de Google afin de comprendre pourquoi et comment corriger ces problèmes.

Mais désormais, les logs sont aussi le moyen le plus fiable de savoir exactement comment les intelligences artificielles interagissent avec votre site web.

Autrement dit : si Google vous montre comment il explore vos pages via la Search Console, les bots IA ne fournissent pas de tels outils. Vos logs sont donc votre unique fenêtre d’observation sur ce nouveau trafic algorithmique.

Découvrez mon article Pourquoi les crawlers IA n'exécutent pas le javascript ?

Les trois grandes familles de bots IA qui explorent le web

Depuis 2023, l’écosystème des IA génératives s’est structuré autour de plusieurs types de bots, chacun ayant une fonction spécifique. Voici les trois catégories principales que l’on retrouve dans les fichiers de logs :

Les bots d’entraînement des LLM

Ces bots ont pour mission de collecter massivement des données publiques pour entraîner des modèles de langage (GPT, Claude, Gemini, etc.).

- Exemples : GPTBot (OpenAI), PerplexityBot (Perplexity), ClaudeBot (Anthropic) ;

- Objectif : alimenter la base de connaissances du modèle ;

- Impact SEO : ces bots ne renvoient aucun trafic, mais leur passage influence la visibilité de vos contenus dans les futurs modèles.

Les bots d’indexation pour plateformes conversationnelles

Ces bots créent des index spécialisés pour leurs moteurs conversationnels. Ils agissent comme des moteurs de recherche hybrides.

- Exemples : Claude-SearchBot (Anthropic), OAI-Search (OpenAI) ;

- Objectif : indexer le web pour construire son propre index de recherche et ne plus avoir à s'appuyer sur des index tiers ;

- Impact SEO : similaire à un moteur de recherche classique, mais sans SERP visible. Ces bots peuvent citer directement vos pages dans leurs réponses.

Les bots de réponse en temps réel (ChatGPT-User, Perplexity-User, etc.)

Ce sont les plus stratégiques pour les marques. Ils sont déclenchés lorsqu’un utilisateur interagit avec un chatbot et que ce dernier estime qu’il n’a pas les connaissances nécessaires pour lui répondre. Dans ce cas, le LLM fait appel à un outil pour déclencher une recherche web afin de récupérer des informations issues de sources externes pour formuler sa réponse :

- Objectif : répondre à une requête utilisateur spécifique en récupérant des pages pertinentes ;

- Impact SEO : ces bots permettent d’identifier quelles URL sont effectivement récupérées par les IA pour formuler une réponse à l’utilisateur dans les réponses générées par les IA ;

- Comme ces bots IA sont déclenchés au nom de l'utilisateur (bots user-triggered), il est admis par convention qu'ils ne sont pas tenus de respecter les directives de votre fichier robots.txt. Interdire le crawl de votre site par GPT-User par exemple est donc inefficace.

L'analyse de mon fichier de logs révèle que le bot ChatGPT-User a visité sur mon site 138 URLs différentes sur la période allant du 17 octobre au 4 novembre 2025 et que, sans surprise, c'est ma homepage qui a été la plus récupérée par le bot IA avec 353 hits.

Ces logs sont précieux : ils révèlent quelles pages de votre site “alimentent” réellement les IA. Ce sont ces contenus qu’il faut, à mon sens, optimiser en priorité.

Pourquoi les bots de réponse en temps réel sont les plus précieux pour votre stratégie de visibilité dans les moteurs IA ?

Contrairement aux bots d’entraînement, qui aspirent votre site web dans sa globalité pour nourrir les IA, ou aux bots d’indexation, qui construisent des bases intermédiaires, les bots de réponse en temps réel (par exemple ChatGPT-User ou Perplexity-User) sont les seuls à générer un effet immédiat de visibilité et de citation.

- Chaque requête utilisateur peut déclencher un crawl ciblé.

- Si votre contenu est jugé pertinent, il peut être cité directement dans la réponse du chatbot.

- Ces citations s’accompagnent souvent d’un lien source (ex : "source : https://julien-gourdon.fr/").

En d’autres termes, vos logs peuvent vous révéler quelles pages sont utilisées pour répondre à des requêtes réelles d’utilisateurs IA. Cela ouvre une nouvelle dimension du SEO : le Generative Engine Optimization (GEO).

Comment adapter votre analyse de logs à cette nouvelle ère

Pour exploiter cette opportunité, votre analyse de logs doit aller au-delà du suivi des bots classiques. Voici les étapes clés :

Étape 1 : Identifier et filtrer les bots IA

- Recherchez les User-Agents : GPTBot, ChatGPT-User, PerplexityBot, ClaudeBot, OAI-Search, etc.

- Classez-les par type : entraînement, indexation, réponse temps réel.

Étape 2 : Analyser la fréquence et les zones explorées

- Quelles sections du site intéressent les IA ?

- Les bots d’IA accèdent-ils à des pages à forte valeur ajoutée ?

- Certaines zones ne sont-elles jamais explorées ?

Étape 3 : Corréler avec vos données Google Analytics 4 (GA4)

- Comparez le trafic issu des plateformes conversationnelles avec leurs bots d’exploration en temps réel. Un contenu est souvent exploré par ChatGPT-User mais ne génère aucun trafic ? C’est peut-être parce que votre page n’est jamais mis en avant par ChatGPT parce qu’il estime que vos concurrents ont de meilleurs contenus ;

- Analysez le comportement des utilisateurs en provenance des plateformes conversationnelles et comparez-le avec le comportement des autres utilisateurs. Sont-ils plus engagés ? Convertissent-ils plus ? Parcourent-ils plus de pages que les autres utilisateurs ?

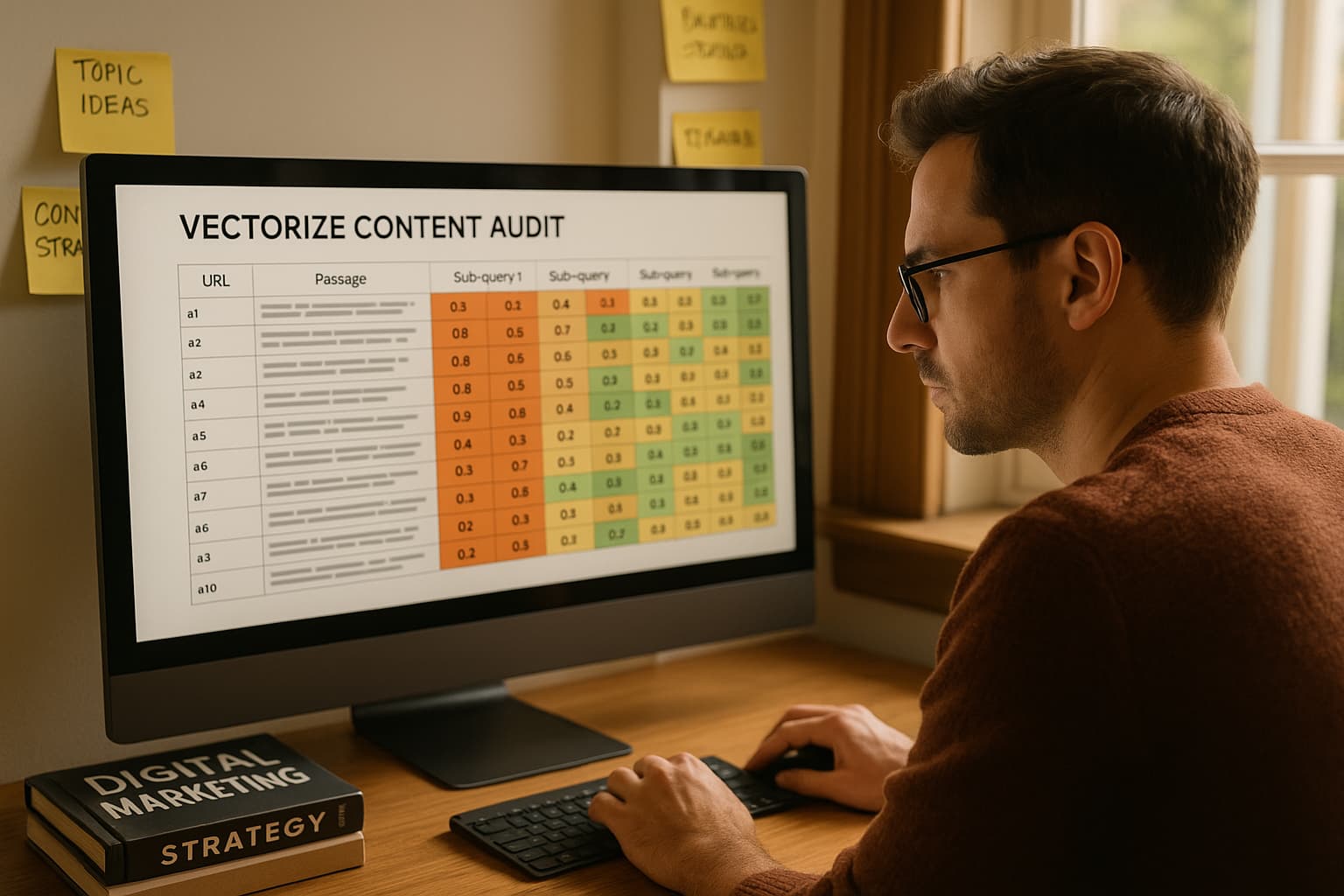

Étape 4 : Prioriser les contenus à optimiser pour l’IA

- Repérez les URL récupérées par les chatbots conversationnels dans leur réponse synthétique ;

- Identifiez, grâce à une analyse croisée issue de la Google Search Console et de la Bing Search Console, sur quelles requêtes ces URLs sont visibles en page 1. Parmi ces requêtes se trouvent celles qui sont générées automatiquement par l’IA via le processus de query fan out. Pouvez-vous encore d’avantage optimiser votre positionnement sur ces requêtes ? Essayez de reconstituer, à partir de ces requêtes, le prompt d’origine de l’utilisateur, puis de récupérer les sous-requêtes générées par la plateforme. Vos URL sont-elles visibles en Page 1 de Google sur ces requêtes de longue traîne ?

- Optimisez vos contenus déjà récupérés par les IA pour en améliorer encore la clarté, la structure, la pertinence contextuelle de chaque section. Mettez à jour les métadonnées et le maillage interne pour renforcer leur autorité. Insérez des données structurées dans ces URLs si ce n’est pas déjà. Voyez-vous un crawl plus fréquent de ces URL optimisées par les bots IA ? Le trafic utilisateur en provenance des moteurs IA décolle-t-il ? Ajustez en conséquence.

L’analyse de logs SEO n’est plus seulement un outil d’audit technique : c’est désormais un instrument d’intelligence stratégique à l’ère de l’intelligence artificielle.

Elle permet de comprendre comment votre site est exploré, indexé et exploité par des entités non humaines qui redéfinissent le web.

Commentaires

Aucun commentaire pour le moment. Soyez le premier à commenter !

Ajouter un commentaire